À mesure que le champ d’application de l’intelligence artificielle (IA) et de l’apprentissage automatique s’étend. L’importance de la protection des données dans les outils d’IA devient de plus en plus grande.

Avec la tendance croissante à la personnalisation de l’IA, les lois sur la protection de la vie privée et les réglementations telles que le Règlement général sur la protection des données (RGPD) mettent davantage l’accent sur la privatisation des données et l’anonymisation des données.

Ce billet propose un guide complet pour comprendre ces concepts clés, leur importance dans la technologie de l’IA et la manière de les mettre en œuvre efficacement.

Comprendre les concepts clés

Définition de la privatisation des données

La privatisation des données est un concept essentiel à l’ère numérique actuelle, car elle répond au besoin fondamental de protéger les informations personnelles et sensibles des individus.

Au-delà du cryptage et des pratiques d’intelligence artificielle sécurisées, il s’agit d’une approche globale de la protection des données.

Cela inclut des contrôles d’accès rigoureux, des mécanismes d’authentification robustes et le respect des réglementations en matière de traitement des données.

En mettant l’accent sur le fait que seules les entités autorisées peuvent accéder aux données, les gérer et les utiliser, la privatisation des données favorise la confiance entre les utilisateurs et les organisations.

Veiller à ce que les informations personnelles soient traitées de manière responsable et éthique, afin d’améliorer la sécurité des données et la protection de la vie privée des particuliers et des entreprises.

Définition de l’anonymisation des données

L’anonymisation des données est une technique cruciale dans le domaine de la confidentialité et de la sécurité des données. Elle consiste à transformer les données de manière à ce qu’il soit pratiquement impossible de les relier à des personnes spécifiques, tout en conservant leur utilité pour l’analyse et la recherche.

En masquant ou en remplaçant les informations identifiables, telles que les noms ou les numéros de sécurité sociale, par des pseudonymes ou des jetons, l’anonymisation des données permet aux organisations de partager des ensembles de données précieux à des fins de recherche, d’analyse ou de collaboration.

Sans enfreindre les réglementations en matière de protection de la vie privée ni exposer les personnes à des risques potentiels de ré-identification.

Cet équilibre entre l’utilité des données et la protection de la vie privée est essentiel dans le monde d’aujourd’hui, où la gestion responsable des données est une priorité absolue.

Apprenez-en plus sur la confidentialité des données dans cette vidéo :

L’importance de la confidentialité des données dans les outils d’IA

La confidentialité des données est indéniablement un aspect essentiel de l’IA et de la protection de la vie privée, étant donné que les outils d’IA ont souvent accès à un vaste ensemble de données personnelles. Cette richesse d’informations fait de la sécurité des données une priorité absolue.

Garantir la confidentialité des données dans le domaine de l’apprentissage automatique et de l’IA n’est pas seulement une question de conformité aux réglementations ; il s’agit de protéger les informations sensibles des individus.

L’une des principales préoccupations dans ce contexte est le risque de violation des données. Une violation se produit lorsque des personnes non autorisées accèdent à des données sensibles et les exploitent.

De tels incidents peuvent avoir des répercussions profondes, allant des pertes financières aux atteintes à la réputation, voire aux conséquences juridiques.

C’est pourquoi il est essentiel de mettre en place des mesures solides de protection de la confidentialité des données afin de prévenir les violations de données et leurs retombées.

En mettant en œuvre des pratiques rigoureuses de confidentialité et d’anonymisation des données, les développeurs d’IA peuvent protéger les informations personnelles des utilisateurs contre tout accès non autorisé et toute utilisation abusive. Cela permet d’instaurer un climat de confiance avec les utilisateurs, en favorisant un sentiment de sécurité et de confiance dans la technologie.

Lorsque les utilisateurs sont convaincus que leurs données sont en sécurité, ils sont plus enclins à utiliser les outils d’IA, à partager des informations et à interagir plus ouvertement, ce qui conduit à une relation IA-utilisateur plus fructueuse et plus harmonieuse.

Le rôle de l’anonymisation des données dans les outils d’IA

L’anonymisation des données joue un rôle crucial dans le maintien de la vie privée tout en personnalisant l’IA et en permettant un partage et une utilisation responsables des données.

En rendant les données anonymes, les outils d’IA peuvent utiliser la richesse des informations disponibles dans les big data sans compromettre la vie privée des utilisateurs.

Ceci est particulièrement important dans le traitement des données d’IA, où l’utilisation responsable des données personnelles peut grandement améliorer l’expérience de l’utilisateur si elle est gérée correctement.

Comment parvenir à la privatisation des données dans les outils ?

Guide de la privatisation des données, étape par étape

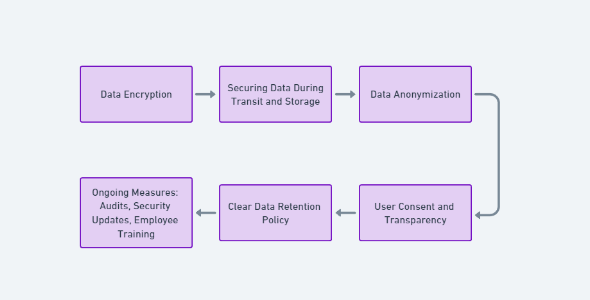

La privatisation des données dans les outils d’IA est un processus à multiples facettes qui exige une approche globale. Cela commence par le cryptage des données, la sécurisation des données pendant le transit et le stockage, et l’application de contrôles d’accès pour s’assurer que seul le personnel autorisé peut y accéder.

Toutefois, ces premières mesures ne sont que la base d’un cadre solide pour la protection de la vie privée.

L’anonymisation des données est un élément crucial, impliquant la transformation ou la suppression des informations personnelles identifiables (PII) afin de protéger la vie privée des individus tout en maintenant l’utilité des données pour les applications d’IA.

Il est essentiel d’établir une politique claire de conservation des données afin de minimiser l’exposition des données et de réduire le risque de violation des données. Cette politique précise la durée de conservation des données et la date à laquelle elles seront éliminées en toute sécurité, garantissant ainsi une gestion responsable des données.

Le consentement de l’utilisateur et la transparence sont des éléments essentiels de la privatisation des données. Les développeurs d’IA doivent obtenir le consentement éclairé des utilisateurs en ce qui concerne la collecte et l’utilisation des données, tout en communiquant de manière transparente sur la manière dont les données seront utilisées et stockées.

Les mesures permanentes comprennent des audits réguliers, des mises à jour de sécurité et des programmes de formation des employés afin de s’adapter à l’évolution des menaces, de contrôler l’efficacité des mesures de protection des données et de maintenir une culture de la confidentialité des données au sein de l’organisation.

Ces efforts collectifs sont indispensables pour parvenir à une privatisation solide des données dans les outils d’IA et pour garantir un traitement responsable des données dans un monde de plus en plus axé sur les données.

Meilleures pratiques en matière de privatisation des données

L’intégration d’une approche « privacy by design » dans le développement d’outils d’IA signifie un engagement proactif en faveur de la protection de la vie privée. Cette approche nécessite que les considérations relatives à la protection de la vie privée soient intégrées de manière transparente dès le départ, à chaque phase du cycle de vie de l’outil d’IA.

Cela comprend non seulement la conception et le développement initiaux, mais aussi le contrôle continu, les mises à jour et les évaluations des risques potentiels en matière de protection de la vie privée.

En intégrant la protection de la vie privée au cœur du processus de conception de l’IA, les entreprises peuvent minimiser la probabilité d’atteintes à la vie privée. Et s’assurer que la confidentialité des données reste un principe fondamental tout au long de l’évolution de l’outil.

En outre, la transparence avec les utilisateurs est primordiale pour instaurer la confiance. Les entreprises doivent communiquer clairement sur la manière dont les données des utilisateurs sont collectées, traitées et stockées.

Cette transparence favorise un sentiment de contrôle et de compréhension chez les utilisateurs, ce qui leur permet de prendre des décisions éclairées quant au partage de leurs données.

Une communication ouverte et honnête sur les pratiques en matière de données renforce la confiance des utilisateurs et peut, en fin de compte, accroître leur engagement et leur satisfaction.

En outre, il est essentiel de se tenir informé de l’évolution des lois et des réglementations en matière de protection de la vie privée dans ce paysage en constante évolution afin de s’adapter et de garantir une conformité permanente, démontrant ainsi un engagement à respecter les normes en matière de protection de la vie privée et les droits des utilisateurs.

Mise en œuvre de l’anonymisation des données dans les outils d’IA

Le processus d’anonymisationdes données

L’anonymisation des données est un processus en plusieurs étapes conçu pour garantir la confidentialité des données tout en répondant aux préoccupations en matière de protection de la vie privée. Dans un premier temps, les données sont collectées avec le consentement de l’utilisateur, dans le respect des directives éthiques et juridiques.

Après la collecte des données, les informations identifiables, telles que les noms et les adresses, sont soit supprimées, soit transformées à l’aide de diverses techniques d’anonymisation telles que le masquage des données, la pseudonymisation et la généralisation.

Ces méthodes visent à rendre difficile l’identification de personnes spécifiques à partir de données anonymes, tout en préservant l’utilité des données à des fins d’analyse et de recherche.

Tout au long du processus, les préoccupations en matière de protection de la vie privée sont primordiales. Il est essentiel de trouver un équilibre entre l’utilité et la protection de la vie privée. Une anonymisation excessive des données peut les rendre inutilisables pour l’analyse, tandis qu’une anonymisation insuffisante peut exposer les individus à des violations de leur vie privée et à des risques de ré-identification.

Il est essentiel de tester rigoureusement les données anonymes pour s’assurer que même les techniques avancées de couplage de données ne peuvent pas réidentifier les données d’origine, ce qui permet de maintenir un niveau élevé de protection de la vie privée.

Dans le paysage actuel centré sur les données, l’anonymisation responsable des données est essentielle pour préserver la vie privée des individus tout en extrayant des informations précieuses des données collectées.

Les meilleurs outils et techniques pour l’anonymisation des données

- L’anonymisation des données, telle que CloverDX, est une pratique fondamentale en matière de confidentialité des données, qui fait appel à des techniques courantes telles que le masquage des données, la pseudonymisation et la généralisation.

- Le masquage des données, tel que le masquage Delphix, consiste à remplacer les données identifiables par des informations fictives mais réalistes, afin de préserver l’utilité de l’ensemble des données tout en dissimulant les identités individuelles.

- La pseudonymisation, comme celle d’Orion, remplace les données identifiables par des identifiants artificiels ou des jetons, ce qui permet de relier et d’analyser les données sans exposer les détails personnels, d’où son intérêt dans le domaine des soins de santé et dans d’autres contextes.

- La généralisation, en revanche, transforme des attributs de données spécifiques en catégories plus larges, ce qui réduit la granularité des données et minimise le risque d’identification des personnes.

Ces méthodes d’anonymisation permettent de trouver un équilibre entre l’utilité des données et la protection de la vie privée, ce qui est essentiel pour le développement et le déploiement de l’IA. En mettant en œuvre ces techniques, les organisations peuvent exploiter la puissance des connaissances fondées sur les données tout en protégeant les informations sensibles et en adhérant à des réglementations strictes en matière de protection de la vie privée.

Ce faisant, il garantit un partage et une utilisation responsables des données dans le paysage en constante évolution de la technologie de l’IA.

Défis et solutions dans la mise en œuvre de la confidentialité et de l’anonymisation des données

Défis

La confidentialité et l’anonymisation des données présentent plusieurs défis, en particulier lorsque les organisations s’efforcent d’exploiter les données volumineuses tout en se conformant à des exigences réglementaires croissantes et en maintenant la confiance du public.

Équilibrer l’utilité des données et la protection de la vie privée :

- Garantir que les données anonymes restent utiles pour l’analyse tout en masquant efficacement les identités individuelles.

Conformité avec des réglementations en constante évolution :

- Se tenir au courant des lois et réglementations en matière de protection de la vie privée, telles que le GDPR et le CCPA, et s’y conformer.

Risques liés à la réidentification des données :

- Prévenir le risque que des données anonymes puissent permettre de remonter à des individus en utilisant des techniques avancées ou en combinant des ensembles de données.

Complexité des techniques d’anonymisation des données :

- Mettre en œuvre des techniques d’anonymisation sophistiquées qui nécessitent une expertise technique approfondie, telles que la confidentialité différentielle et le cryptage homomorphique.

Allocation des coûts et des ressources :

- Allouer des ressources et un budget suffisants pour mettre en œuvre et maintenir des programmes efficaces de protection de la vie privée et d’anonymisation des données.

Perception et confiance du public :

- Instaurer et maintenir la confiance du public en démontrant son engagement en faveur de la protection de la vie privée et de l’utilisation éthique des données.

Solutions

Face à la multiplication des réglementations et à la sensibilisation croissante des consommateurs, les entreprises doivent adopter des solutions robustes pour la privatisation et l’anonymisation des données. Ces mesures permettent non seulement de protéger les informations sensibles, mais aussi de favoriser la confiance et la conformité.

Mettre en œuvre la confidentialité différentielle :

- Ajouter un bruit aléatoire aux données ou utiliser des techniques statistiques pour s’assurer que les points de données individuels ne peuvent pas être retracés jusqu’aux personnes concernées, tout en permettant une analyse significative des données agrégées.

Utiliser l’apprentissage fédéré :

- Traiter les données localement sur les appareils des utilisateurs et ne partager avec le serveur central ou le nuage que les mises à jour des modèles ou les informations, et non les données brutes elles-mêmes. Cela minimise le risque d’exposition des données et améliore la confidentialité.

Appliquer le chiffrement homomorphique :

- Chiffrer les données de manière à ce qu’elles puissent être traitées ou analysées sans être déchiffrées. Cela permet d’utiliser les données dans des calculs en toute sécurité sans exposer les informations sous-jacentes.

Masquage des données et tokénisation :

- Remplacer les éléments de données sensibles par des équivalents non sensibles, connus sous le nom de jetons, qui peuvent être ramenés aux données d’origine par le biais d’un système de symbolisation sécurisé, ou masquer les données pour cacher les identifiants personnels.

Minimisation des données :

- Ne collecter que les données strictement nécessaires à l’objectif visé et éviter de stocker des informations excessives susceptibles d’accroître les risques d’atteinte à la vie privée. Cela inclut également la suppression des données qui ne sont plus nécessaires.

Audits réguliers de la protection de la vie privée et évaluations d’impact :

- Procéder à des évaluations régulières afin d’identifier et d’atténuer les risques en matière de protection de la vie privée associés aux activités de traitement des données. Il s’agit notamment d’examiner les pratiques de collecte, de stockage et de traitement des données pour s’assurer qu’elles sont conformes aux lois et réglementations en matière de protection de la vie privée.

L’avenir de la confidentialité des données et de l’anonymisation dans les outils d’IA

Au fur et à mesure que la technologie de l’IA progresse, elle fait apparaître des approches évolutives de la confidentialité et de l’anonymisation des données, avec une attention particulière portée à la vie privée des individus.

L’émergence de l’informatique quantique promet un cryptage inviolable, qui pourrait renforcer la protection des données et sauvegarder la vie privée des individus dans une mesure sans précédent.

En outre, l’évolution des réglementations, telles que le Règlement général sur la protection des données (RGPD) et ses équivalents mondiaux, continue de façonner le paysage des données dans l’apprentissage automatique et l’IA par le biais des lois sur la protection des données.

Ces règlements soulignent les droits des individus à contrôler leurs données personnelles et nécessitent des mesures de protection solides.

Les développeurs d’IA et les spécialistes des données doivent donc rester vigilants et veiller à ce que leurs systèmes d’IA soient non seulement conformes aux réglementations existantes, mais qu’ils accordent également la priorité à la protection de la vie privée des personnes tout au long du cycle de vie des données.

Dans cet environnement dynamique, le défi consiste à trouver un équilibre délicat entre les avantages potentiels de l’IA et la préservation du droit à la vie privée.

L’adaptation et l’innovation en matière d’utilisation des données et de techniques d’anonymisation seront essentielles pour répondre à l’évolution des exigences de l’ère numérique tout en préservant la confidentialité et la sécurité des données individuelles.

Conclusion

La mise en œuvre de pratiques efficaces de privatisation et d’anonymisation des données dans les outils d’IA est une tâche complexe qui nécessite une compréhension approfondie de la technologie de l’IA et des lois sur la protection de la vie privée.

Cependant, avec les bonnes stratégies et techniques, les entreprises peuvent réussir à trouver un équilibre entre le besoin d’utilité des données et l’impératif de protection de la vie privée des utilisateurs.

Cela permet non seulement d’assurer la conformité avec les réglementations en matière de protection de la vie privée, mais aussi d’instaurer la confiance avec les utilisateurs, ce qui améliore l’expérience globale de l’utilisateur.

Vous cherchez à développer la bonne solution d’IA pour protéger vos données et la vie privée de vos clients ? Contactez nos experts chez iterates.